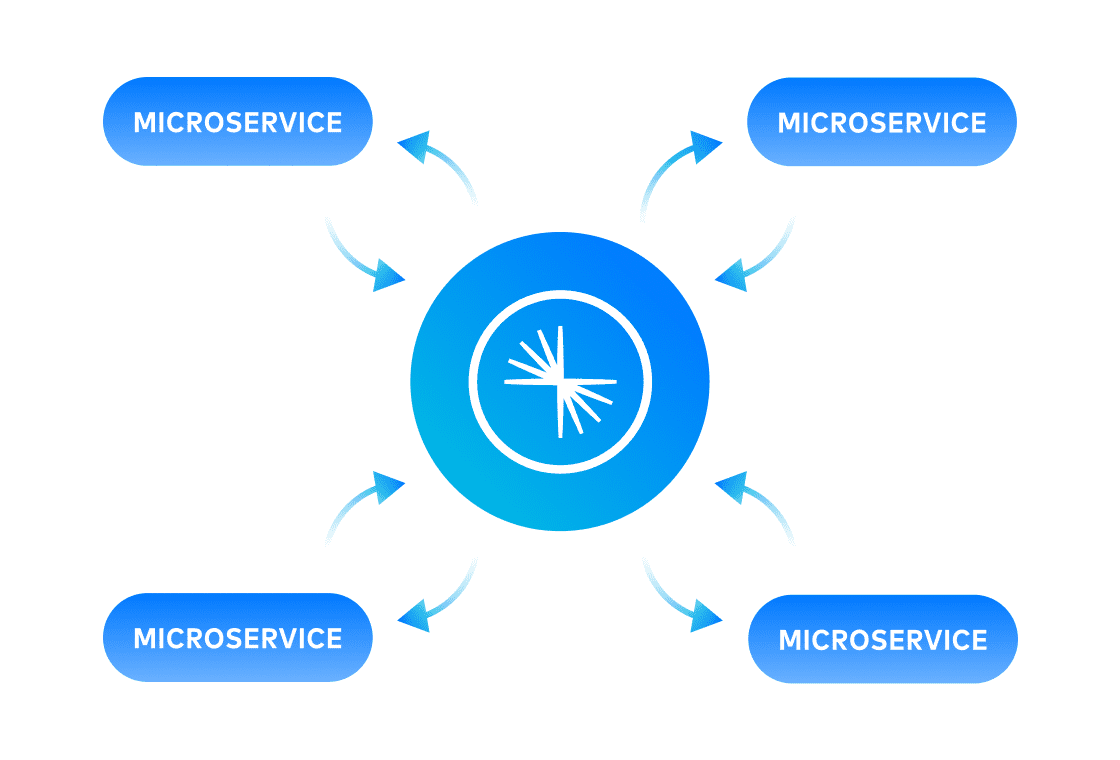

Event-getriebene Microservices

Flexibel miteinander verknüpfte Microservices erhöhen die Flexibilität und beschleunigen Innovationen. Mit Confluent können Microservices vollständig entkoppelt und die Kommunikation zwischen den Services standardisiert werden. Die Pflege unabhängiger Datenzustände ist nicht mehr notwendig.